SLAM mit LiDAR: Unterschied zwischen den Versionen

Keine Bearbeitungszusammenfassung |

Keine Bearbeitungszusammenfassung |

||

| Zeile 9: | Zeile 9: | ||

Mobile Roboter, wie beispielsweise Saugroboter, müssen wissen, wo sie sich befinden, um effizient zu reinigen. Hierzu müssen sie ihre Umgebung kartografieren und sich in dieser entstehenden Karte selbst lokalisieren. | Mobile Roboter, wie beispielsweise Saugroboter, müssen wissen, wo sie sich befinden, um effizient zu reinigen. Hierzu müssen sie ihre Umgebung kartografieren und sich in dieser entstehenden Karte selbst lokalisieren. | ||

== | == Aufgabe == | ||

Realisieren Sie einen SLAM-Algorithmus mit LiDAR-Sensorik. | Die Aufgabe dieser Arbeit ist es, mithilfe eines LEGO EV3 kombiniert mit dem XV11-LiDAR(Light Detection and Ranging) die Umgebung zu erkennen und auszuwerten. Im nachfolgenden Schritt, sollen die Daten dazu genutzt werden eine Umgebungskarte zu erstellen um eine Karte in der Unity-Engine zeichnen zu können. | ||

Zur besseren Projektübersicht und Planung teile ich das Vorhaben, wie folgt, in mehrere Abschnitte auf: | |||

# Entwurf und Bau des LEGO© EV3- Roboters | |||

# Montage des Sensors durch eine in SolidWorks entworfene Montageplattform (3D-Druck) incl. Verkabelung | |||

# Errichtung einer Cross-Compiler-Toolchain | |||

# Inbetriebnahme des Sensors und Programmierung | |||

# Darstellung der Umgebung in Unity© | |||

# Realisieren Sie einen SLAM-Algorithmus mit LiDAR-Sensorik. | |||

== Erwartungen an die Projektlösung == | |||

*Inbetriebnahme des LiDAR | |||

*Schnittstelle LiDAR zu EV3 z.B. mit Matlab/Simulink | |||

*Messdatenauswertung auf dem EV3 | |||

*Bewertung der Ergebnisse | |||

*Softwareentwicklung nach HSHL Standard in SVN | |||

*Machen Sie spektakuläre Videos, welche die Funktion visualisieren. | |||

*Test und wiss. Dokumentation | |||

*Live Vorführung während der Abschlusspräsentation | |||

== Anforderungen == | == Anforderungen == | ||

| Zeile 34: | Zeile 53: | ||

* [https://essay.utwente.nl/71535/1/Folmer_MA_EEMCS.pdf] | * [https://essay.utwente.nl/71535/1/Folmer_MA_EEMCS.pdf] | ||

* [[Projekt_70c:_Labyrinth_SLAM_mit_EV3]] | * [[Projekt_70c:_Labyrinth_SLAM_mit_EV3]] | ||

*[https://www.ev3dev.org/docs/tutorials/using-xv11-lidar/] | |||

*[https://www.youtube.com/watch?v=G6uVg34VzHw] | |||

== Literatur == | == Literatur == | ||

| Zeile 48: | Zeile 69: | ||

---- | |||

→ zurück | <!-- Kopieren Sie diesen Header in Ihren Artikel, damit er aufgelistet wird. --> | ||

'''Autoren:''' [[Benutzer:Alexander_Schirrmeister|Schirrmeister, A.]] | |||

<br/> | |||

'''Betreuer:''' [[Benutzer:Ulrich_Schneider| Prof. Schneider]]<br/> | |||

→ zurück zur Übersicht: [[Studentische_Arbeiten|Studentische Arbeiten]] | |||

Version vom 13. Januar 2020, 12:38 Uhr

Autoren: Arndt, S.

Betreuer: Prof. Schneider

Art: Projektarbeit

Projektlaufzeit: TBD

Motivation

Mobile Roboter, wie beispielsweise Saugroboter, müssen wissen, wo sie sich befinden, um effizient zu reinigen. Hierzu müssen sie ihre Umgebung kartografieren und sich in dieser entstehenden Karte selbst lokalisieren.

Aufgabe

Die Aufgabe dieser Arbeit ist es, mithilfe eines LEGO EV3 kombiniert mit dem XV11-LiDAR(Light Detection and Ranging) die Umgebung zu erkennen und auszuwerten. Im nachfolgenden Schritt, sollen die Daten dazu genutzt werden eine Umgebungskarte zu erstellen um eine Karte in der Unity-Engine zeichnen zu können.

Zur besseren Projektübersicht und Planung teile ich das Vorhaben, wie folgt, in mehrere Abschnitte auf:

- Entwurf und Bau des LEGO© EV3- Roboters

- Montage des Sensors durch eine in SolidWorks entworfene Montageplattform (3D-Druck) incl. Verkabelung

- Errichtung einer Cross-Compiler-Toolchain

- Inbetriebnahme des Sensors und Programmierung

- Darstellung der Umgebung in Unity©

- Realisieren Sie einen SLAM-Algorithmus mit LiDAR-Sensorik.

Erwartungen an die Projektlösung

- Inbetriebnahme des LiDAR

- Schnittstelle LiDAR zu EV3 z.B. mit Matlab/Simulink

- Messdatenauswertung auf dem EV3

- Bewertung der Ergebnisse

- Softwareentwicklung nach HSHL Standard in SVN

- Machen Sie spektakuläre Videos, welche die Funktion visualisieren.

- Test und wiss. Dokumentation

- Live Vorführung während der Abschlusspräsentation

Anforderungen

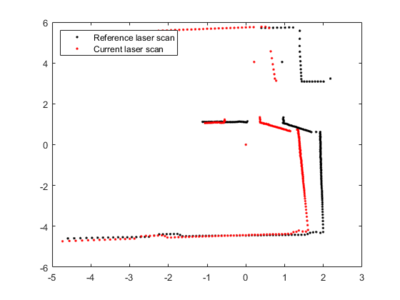

- Recherchieren Sie nach Methoden zum LiDAR SLAM und wählen Sie ein effizientes Verfahren aus (z.B. Scan-Matching).

- Zeichnen Sie als Eingangsdaten Roboterfahrten (LiDAR und Odometrie) auf (z.B. LiDAR am EV3).

- Verarbeiten Sie diese Eingangsdaten mit MATLAB oder Simulink.

- Nutzen Sie einen existierenden Parkours (z.B. hier)

- Stellen Sie Ihre Ergebnisse in MATLAB/Simulink dar.

- Stellen Sie die Objekte im Sichtfeld in der Draufsich metrisch dar.

- Schätzen Sie die Genauigkeit Ihres Algorithmus ab.

- Wissenschaftliche Dokumentation als HSHL-Wiki Artikel

- Softwareentwicklung nach HSHL Standard in SVN

- Funktionsnachweis als YouTube-Video

Video

Verlinken Sie hier ein YouTube-Video zu Ihrem fertigen Projekt. Tipps zum Video finden Sie hier.

Weblinks

- SLAM Course - 12 - Scan-Matching in 5 Min - Cyrill Stachniss

- Simultaneous Localization And Mapping (SLAM) with Scan Matching

- Iterative Closest Point algorithm for point clouds in Matlab

- [1]

- [2]

- Projekt_70c:_Labyrinth_SLAM_mit_EV3

- [3]

- [4]

Literatur

Siehe auch

BSD-Lizenzbedingung BSD-Lizenz

Copyright (c) 2018, Hochschule Hamm-Lippstadt, Dep. Lip. 1, Prof. Schneider

Hochschule Hamm-Lippstadt. Alle Rechte vorbehalten.

Autoren: Schirrmeister, A.

Betreuer: Prof. Schneider

→ zurück zur Übersicht: Studentische Arbeiten