Legosortiermaschine Bildverarbeitung

Dies ist ein Unterarikel von der Legoteil_Zählmaschine, welcher den genauen Aufbau der Bildverarbeitung beschreibt.

Ziele und Aufgaben im Semeseter 2017/2018

Team: Jan Auf der Landwehr, Matthias Maas

Ziel: Alle Teile werden richtig erkannt und aufgelistet. Dabei soll eine GUI die Bedienung benutzerfreundlich machen und ein Teach-In von neuen Teilen zur Verfügung stellen.

Aufgaben:

- Hardware und Software starten und Bedienungsanleitung ergänzen

- GUI verbessern

- Datenbank pflegen

- Teach-In über GUI ermöglichen

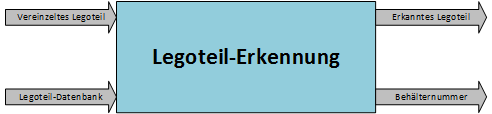

Schnittstellen

Damit die Bildverarbeitung und damit auch das Erkennen der Legoteile erfolgreich verlaufen kann, müssen zunächst die Legoteile vereinzelt in die Bildverarbeitungsbox gelangen (Separierung). Sobald ein Legoteil erkannt wurde, wird es aus der Box per Druckluft gefördert und muss anschließend sortiert werden. Damit das Legoteil richtig sortiert wird, wird dem jeweiligen Legoteil anhand der ID eine Box zugeorndet. Der Schnittstellenplan lässt sich zusammengefasst folgendermaßen darstellen:

Mechanischer Aufbau

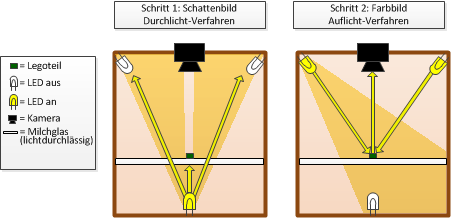

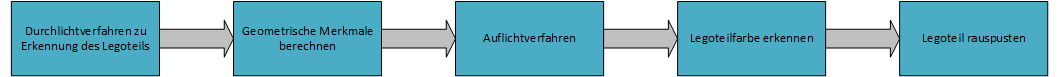

Um die Lichtreflexionen und Schatten an den Legoteilen während der Bilderkennung zu vermeiden, wurde ein neues Konzept entwickelt. Wenn ein Legoteil sich auf einem halb-transparentem Milchglas befindet (siehe Skizze), wird zuerst die untere Beleuchtung eingeschaltet und mittels einem Durchlichtverfahren die genaue Kontur des Legoteils mit der Kamera ermittelt. Hier können bereits einige Merkmale genau extrahiert werden (geometrische) und eine Maske erzeugt werden. Anschließend wird das untere Licht ausgeschaltet und das obere Licht eingeschaltet. Nach diesem Schritt wird mit Hilfe der Maske, nur in dem Bereich wo das Legoteil liegt, die Farbe ermittelt.

Im nächsten Schritt wurde die Idee mit Hilfe eines CAD-Programms ausgearbeitet. Die Konstruktion wurde für den ersten Prototypen einfach gehalten und sich so für miteinander verschraubte Holzbretter entschieden.

In der unteren Box am oberen Rand wurde die halb-transparente Plexiglasplatte angebracht. In einem bestimmten Abstand wurde unter der Plexiglasscheibe eine weitere Ebene mit LEDs platziert. Der Abstand wurde so gewählt, dass bei angeschalteten LEDs das Licht durch das Plexiglas optimal gestreut wird (ohne helle Punkte, ohne Licht-Spots).

In der oberen Box wurde im Deckel eine Bohrung durchgeführt, wo die Stromleitungen der Kamera und der LEDs durchlaufen können. Die LEDs wurden in rechteckiger Form angeordnet und von innen an Deckplatte befestigt (siehe Abbildung 9). Auf einer weiteren halb-transparenten Plexiglasplatte wurde die Kamera befestigt. Für die Kamera wurde eine weitere Bohrung erzeugt. In der oberen Box wurden Ein- und Ausgänge für die Legoteile erzeugt, sowie eine Aussparung für eine flache Druckluftdüse. Zur besseren Vorstellung befindet sich unter den folgenden Link das CAD-Modell als 3dxml-Datei:

BV_Box_Komplett.3dxml. Der 3dxml viewer ist unter folgenden Link zu finden: Link

Anhand des CAD-Modells wurde die Bildverarbeitungsbox fertiggestellt und in Gesamtsystem integriert.

Desweiteren wurde eine "Drosselklappe" prototypisch für die Vor-Separierung in Y-Richtung realisiert.

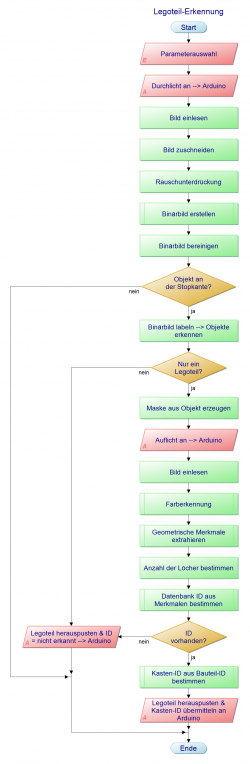

Grober Ablauf der Legoteilerkennung

Matlabimplementierung

Das Programm für die Erkennung von Legoteilen befindet sich hier: AutomatischesZaehlen. Der Funktion wird ein kalibriertes Kameraobjekt, die Schnittstelle zur Datenbank, die serielle Schnittstelle zum Arduino und das Kalibrierbild übergeben. Als Rückgabewert wird eine Liste mit den gezählten Legoteil-IDs zurückgegeben. Das Programm wird in der Hauptfunktion in einer Schleife abwechselnd mit dem Separierungsprogramm aufgerufen. Bei jedem Durchlauf werden dann die jeweiligen Kameras aufgerufen und ein Frame ausgewertet.

Parametrisierung der Kamera:

Für die Einstellungen der Paramter wurde das Matlabtool Image Acquisition Toolbox benutzt. Dort wurden einzelne Parameter so ausgetestet/eingestellt, dass sich zum einen die Legoteile beim Durchlichtverfahren gut vom Hintergrund abgrenzen und zum anderen die unterschiedlichen Legofarben beim Auflichtverfahren erkennen lassen. Folgende Einstellungen wurden getroffen (Die Einstellungsdatei ist hier zu finden):

cam.BacklightCompensation = 0;

cam.Tilt = 0;

cam.Sharpness = 128;

cam.Pan = 0;

cam.Saturation = 128;

cam.Brightness = 128;

cam.Contrast = 128;

cam.Gain = 0;

cam.ExposureMode = 'manual';

cam.FocusMode = 'manual';

cam.WhiteBalanceMode = 'manual';

cam.WhiteBalance = 4000;

cam.Focus = 10;

cam.Exposure = -3;

Kamera-Kalibrierung:

Obwohl die Parameter der Kamera konstant und unverändert waren, stellte sich heraus, dass das Bild der Kamera bei einigen Programmstarts trotzdem heller war. Um Neustarts des Programms zu vermeiden wurde so eine Kalibrierfunktion geschrieben, welche anhand eines aufgenommenen Bildes erkennt, ob die Kameraeinstellungen korrekt vorgenommen.

Dabei wird in einer Schleife ein Kameraobjekt erzeugt und mit den oben aufgeführten Einstelllungen/Parametern versehen. Nun wird ein Bild mit diesen Einstellungen geschossen (im Auflichtverfahren) und mit einem zuvor gespeicherten Bild (siehe Abbildung 12), welches die richtigen Einstellungen beinhaltet, verglichen. Sollten sich die durchschnittliche Helligkeiten der Bilder Unterschiede aufweisen, wird das Kameraobjekt neu erzeugt und der Vorgang wiederholt sich, bis die richtigen Einstellungen getroffen wurden.

Zusammenfassend beschreibt folgendes Diagramm den Ablauf der Selbstkalibrierung:

Das Kalibrierbild befindet sich im folgenden Ordner: Calib_Img.

Legoteilerkennung:

Die Legoteilerkennung erfolgt in einer Schleife, in welcher jeder einzelne Frame ausgewertet wird. Zum Beenden der Schleife und damit des Programms muss hier die Escape-Taste gedrückt werden.

Vorverarbeitung, Segmentierung & Nachverarbeitung:

Zunächst wird das im Durchlichtverfahren aufgenommene Bild zugeschnitten, damit unnötige Bildregionen nicht bearbeitet werden müssen. Die Anzahl an Pixeln, welche in Höhe und Breite weggeschnitten werden, wurde experimentell ermittelt und so ausgelegt, dass sich das größte Legoteil immer im Blickfeld befindet.

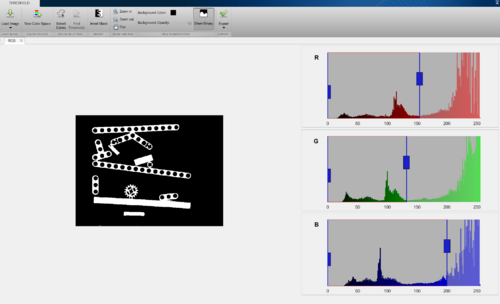

Daraufhin erfolgt die Binarisierung bzw. Segmentierung. Die Schwellwerte für die jeweiligen Farbkanäle und die Funktion zur Binarisierung wurden mithilfe des Matlabtools Color Thresholder ermittelt. Sollte sich im Laufe des Projektes die Kamerabox verändern (z.B. mehr LEDs eingebaut oder ein anderer Lichteinfall) muss diese Funktion ersetzt werden, da es sonst zu Segmentierungsfehlern kommen kann.

Die Funktion zur Segmentierung findet man hier: createBinary_V3

Im Anschluss werden noch kleine, einzelne Pixel im Hintergrund und im Legoteil gelöscht. Damit ist das Bild bereinigt und vollständig segmentiert.

Legoteilerfassung:

Damit ein Legoteil erfasst werden kann, müssen folgende Kriterien eingehalten werden:

- Legoteil muss sich an der Kante befinden

- Legoteil muss sich in einer Ruhelage befinden

- Es darf nur ein Legoteil im Bild vorhanden sein

Sollte mehr als ein Legoteil ein Bild sein, werden alle vorhandenen Legoteile in der Box herausgepustet und als "nicht erkannt" deklariert. Um zu verhindern, dass ein Teil rausgepustet wird, weil zum Beispiel anders beleuchtete Bereiche der Seiten/Löcher als einzelne Teile erkannt werden, wird das Teil zunächst um einige Pixel dilatiert (vergrößert) und anschließend dilatiert (verkleinert). Auf diese Art können kleine Lücken geschlossen werden und die Anzahl an falsch erkannten richtigen Teilen vermieden werden.

Farbliches Merkmale extrahieren:

Damit die Farbe erkannt werden kann, wird das Auflichtverfahren angewendet. Die Funktion "FARBERKENNUNG_V2" bekommt als Übergabewerte zwei Matrizen:

- RGB-Bild aus Auflichtverfahren und Binärbild vom erkannten Objekt

- mit Hilfe der Übergabeparameter wird eine 3D-Farbmaske erstellt (3D --> RGB).

- Farbmaske: Aus dem Originalbild werden nur die Pixel in die Masken übernommen, die im Binärbild dem Objekt zugeordnet werden können (weiße Pixel)

- Anschließend werden Mittelwerte für Rot-, Grün- und Blau-Anteil berechnet.

Zuordnung zur nächstgelegenen Farbe:

- Es werden die RGB-Mittelwerte mit einer Farbtabelle verglichen:

- die Differenzen von jedem Farbanteil zur Farbtabelle werden ermittelt. Davon werden die Differenzen des Farbanteils mit dem größten Wert (Abweichung) gespeichert.

- Anschließend wird der minimalste Wert von den maximalen Abweichungen ermittelt --> Es wird genau die Farbe ermittelt, welches die kleinste Abweichung zu der Legoteil-Farbe hat.

Die ermittelte Farbe wird als String zurückgegeben. Es können weitere Farben im Nachhinein hinzugefügt werden oder Farbschwellwerte verändert werden, falls sich die Lichtverhältnisse in der Kamerabox durch Umbauten verändern.

</source>

Die Farbe wird als Durchschnitt der an R-, G- und B-Anteile pro Fläche berechnet:

FARBE(1,1) = (sum(sum(Farbmaske(:,:,1))))/Pixel_Flaeche;

FARBE(1,2) = (sum(sum(Farbmaske(:,:,2))))/Pixel_Flaeche;

FARBE(1,3) = (sum(sum(Farbmaske(:,:,3))))/Pixel_Flaeche;

Sollten diese (z.B. nach einem Umbau der Bildverarbeitungsbox) von den Werten in der hinterlegten Tabelle stark abweichen, müssen diese mit dem gemessenen Wert überschrieben werden:

%% Farbwerte-Tabelle mit normierten Lego-Farben

% % R(1) G(1) B(1)

Farbwerte=[ 0.5273 0.5489 0.5362; %'weiss'

0.4138 0.3891 0.3115; %'beige'

0.3230 0.0622 0.0623; %'rot'

0.0087 0.1275 0.3309; %'blau'

0.5409 0.4596 0.2026; %'gelb'

0.0450 0.0664 0.0659; %'schwarz'

0.0509 0.1826 0.1287; %'gruen'

0.2182 0.2038 0.1518; %'hellbraun'

0.2709 0.3230 0.3345; %'hell-grau'

0.1391 0.1804 0.1878; %'dunkel-grau'

% 0.0565 0.0629 0.0552; %'dunkelbraun'

];

Geometrische Merkmale extrahieren:

Die Funktion "Merkmalsberechnung_V3" erhält als Übergabeparameter ein Binärbild eines einzelnen Objektes (Legoteil). Aus diesem Objekt werden dann folgende Merkmale extrahiert, welche dann zurückgegeben werden:

- Umfang --> Anzahl der Pixel, die sich am Rand des Objektes befinden

- Fläche --> Anzahl der Pixel, die sich innerhalb des Objektes befinden (Löcher ausgeschlossen)

- Flächenschwerpunkt --> Pixelkoordinaten {x/y}

- Minimaler Abstand von Flächenschwerpunkt zu äußerem Rand des Objektes

- Maximaler Abstand von Flächenschwerpunkt zu äußerem Rand des Objektes

Die Berechnung der Fläche erfolgt über die Summenbildung der Zeilen und Spalten des Binärbildes. Da so nur die weißen Pixel addiert werden, handelt es sich hierbei nur um die Pixel, die zum Objekt gehören.

Die Schwerpunktskoordinaten lassen sich mit der Matlab-Funktion Regionprops berechnen, welche als Übergabeparameter das Binärbild des Objektes und die Option 'centroid' erhält.

Mithilfe des Kantenbildes des Objektes (erzeugt mit der Matlab-Funktion bwperim), kann eine Liste mit allen Kantenkoordinaten erstellt werden (Matlab-Funktion: Regionprops(Kantenbild, 'Pixellist')). Aus der Differenz zwischen jedem einzelnen dieser Kantenpixel und dem Schwerpunkt bestimmt man nun die Abstände vom Schwerpunkt zum Rand, welche nach minimalen und maximalen Wert durchsucht werden.

Anhand der Größe der Kantenpixelliste kann außerdem der Umfang des Objektes bestimmt werden.

Diese Merkmale dienen, zusätzlich zu der Farbe des Objektes und die Anzahl der Löcher im Objekt, als Indikatoren für den Abgleich zwischen aktuellen Legoteil in der Box und den hinterlegten Daten in der Datenbank (siehe Funktion: "+ Excel\Datenbankabgleich.m Datenbankabgleich.m").

Sollten sich herausstellen, dass diese Merkmale nicht genügen, um alle Legoteile voneinander unterscheiden zu können, sind weitere Merkmalsberechnungen möglich (z.B. Die Seitenlängen einer um das Objekt aufgespannten Boundingbox).

Herauspusten der Legoteile:

Sobald alle Merkmale erfasst wurden, werden diese mit einer Datenbank abgeglichen und einer Legoteil-ID zugeordnet, anhand derer man die zugehörige Box (des Linearläufers) ermittelt und mitteilt (siehe Funktion: "+ Excel\BoxausID_SwitchCaseDB.m BoxausID_SwitchCaseDB.m"). Danach erfolgt das Herauspusten des Legoteils aus der Kamerabox. Um herauszufinden, wann der Herauspusten beendet werden kann, wird das aktuelle Kamerabild (bei Auflichtverfahren) mit dem Kalibrierbild verglichen. Sollten hier keine großen unterschiede vorliegen, ist die Box leer und das Ventil der Druckluftdüse kann geschlossen werden.

[1] [2]

[3] [4]

Teach In

Das Teach In erfolgt über die Auswahl im Hauptmenu. Dazu muss das Programm über die Funktion StartSortiermaschine gestartet werden.

Die Anleitung, wie das die Hauptfunktion zu benutzen ist, ist hier zu finden.

Zur Erkennung der Merkmale werden die gleichen Funktionen verwendet wie in der Hautpunktion. Nach der Aufnahme eines Bildes wird mit createBinary_V3 das Binärbild erstellt und die Merkmale über

Bildverarbeitung_Teach_In berechnet.

Mit FARBERKENNUNG_V2 wird die Farbe des eingelegten Legoteils erkannt. Anschließend werden die Merkmale in einem cell-Array gespeichert.

Header{1,1} = 'LegoteileID';

Header{1,2} = 'Bezeichnung';

Header{1,3} = 'Farbe';

Header{1,4} = 'Form';

Header{1,5} = 'Umfang';

Header{1,6} = 'Flaeche';

Header{1,7} = 'MaxSchwerpunkt';

Header{1,8} = 'MinSchwerpunkt';

Header{1,9} = 'Rundloch';

Header{1,10} = 'AnzPerspektive';

Header{1,11} = 'Scanbar';

Die Einträge "Bezeichnung", "Form", "AnzPerspektive" und "Scanbar" werden in der aktuellen Version nicht verwendet und sind nur noch im Code, weil die Einträge an anderen Stellen erwartet werden (beispielsweise in der SQL Datenbank). Zur besseren Übersichtlichkeit des Codes können diese in zukünftigen Versionen noch entfernt werden.

Fortschritt im SoSe 2017

Am Anfang haben wir uns in das Programm eingearbeitet und uns mit verschiedenen Problemen auseinandergesetzt:

- Wie funktioniert das Programm?

- Welche Unterprogramme sind entscheidend?

- Wie funktioniert die Verbindung zu SQL?

- Wie funktioniert die GUI-Programmierung?

Danach haben wir begonnen, kleinere Bugfixes zu programmieren, damit das Programm allgemein runder läuft. Es ist nun ohne Abstürze über eine GUI steuerbar und Teile werden direkt in SQL gespeichert. Wir haben auch bereits begonnen, neue Teile einzuteachen. Wir haben alles geschafft, was wir uns für dieses Semester vorgenommen haben und sogar mit Aufgaben begonnen, die eigentlich für das nächste Semester geplant waren.

Fortschritt im WiSe 2017/18

In diesem Semester haben wir die Separierung mit dem Hauptprogramm zusammengeführt. Außerdem wurde die Inventurliste in der SQL-Datenbank geleert, um leere Felder auszumerzen, und anschließend wieder vollständig mit den Daten des Grundsets und des Erweiterungssets gefüllt. Das Grundset wurde vollständig eingeteacht (ausgenommen der großen Legoteile wie Motor, Sensoren und EV3 Brick, die vorher händisch aussortiert werden müssen). Schließlich wurde der Wiki-Artikel auf den neuesten Stand aktualisiert.