Objekterkennung mit RP Lidar A1M8: Unterschied zwischen den Versionen

| Zeile 137: | Zeile 137: | ||

Dabei sind die blauen Punkte Messwerte vom RPLiDAR und die roten Linien sind die gefundenen Objekte (Segmente). | Dabei sind die blauen Punkte Messwerte vom RPLiDAR und die roten Linien sind die gefundenen Objekte (Segmente). | ||

Einzelne blaue Punkte werden aufgrund des Nahbereichs oder eines zu großen Abstands zueinander nicht berücksichtigt (gefiltert) | Einzelne blaue Punkte werden aufgrund des Nahbereichs oder eines zu großen Abstands zueinander nicht berücksichtigt (gefiltert) | ||

Aus diesen Segmenten lassen sich Objekte bilden. Die Objekte werden mit einer Breite, Tiefe und Objektausrichtung bestimmt. | |||

== Attribute == | == Attribute == | ||

Version vom 17. Juni 2019, 07:47 Uhr

Autor: Thomas Miska

Betreuer: Prof. Schneider

Aufgabenstellung

- Einarbeitung in die bestehende Software

- Softwareentwurf in MATLAB

- Meilenstein 1:

- Ansteuerung des RP LiDAR A1M8

- Koordinatentransformation polar- zu karthesisch

- Testdokumentation der KOS-Trafo

- Objektbildung (z.B. Sukzessiv Edge Following)

- Testdokumentation der Objektbildung

- Meilenstein 2:

- Objekttracking (mit Kalman-Filter)

- Testdokumentation des Objekttrackings

- Attribute schätzen: v, a, B, T, Güte (s. Schnittstellendokument)

- Testdokumentation der Attribute mit Referenz

- Dokumentation im Wiki

- Meilenstein 1:

- Softwareentwurf in C

- Meilenstein 3:

- Test der Kommunikation Kamera/LiDAR mit DS1104

- Testdokumentation

- Diagnoseseite in ControlDesk

- Darstellung der LiDAR-Objekte als XY-Plot und tabellarisch

- ggf. Fertigstellung der Kommunikation

- Meilenstein 4:

- Plausibilisierung der Messdaten (LiDAR, Kamera)

- Referenzmessungen

- Abschätzung der Güte der Spurerkennung und des Objekttrackings

- Dokumentation im Wiki

- Meilenstein 3:

Softwareentwurf in MATLAB

Ansteuerung des RP LiDAR A1M8

Die Ansteuerung des RPLiDAR mit MATLAB Erfolgt in Verbindung mit einer SDK welche in C-Code geschrieben ist. Dieser Code ist in GitHub frei zugänglich. Der RPLiDAR liefert uns in diesem Fall folgende Messwerte:

- Radius

- Radiant

- Qualität

Die beiden folgenden Messdaten konnten nicht spezifiziert werden und wurden im weiteren Verlauf auch nicht verwendet. Sie befinden sich jedoch im Algorithmus, da der C-Code diese zurückgibt und diese schlussendlich definiert werden müssen.

- bNewScan

- Result

Die Verbindungsart beruht auf eine UART - Schnittstelle, die mithilfe eines Chips ermöglicht wird. Um den COM-Port zu definieren wird ein Textdokument zu Hilfe genommen, in es weitere Einstellungsmöglichkeiten gibt. Die Verwendung eines Textdokument liegt an daran, dass der C-Code ebenfalls darauf zugreift.

Quellcode in MATLAB

% Lade Bibliothek

hardwarex_init;

% Stelle Verbindung mit RPLiDAR her

pRPLIDAR = CreateRPLIDAR();

[result] = ConnectRPLIDAR(pRPLIDAR, 'RPLIDAR0.txt') % Lade die Konfigurationsdatei

disp('Neue Verbindung hergestellt')

[...]

Der Aufruf einer Messung erfolgt über folgenden Befehl:

[result, distance, angle, bNewScan, quality] = GetScanDataResponseRPLIDAR(pRPLIDAR);

Nach folglich ist der Code für das schließen der Verbindung:

Der Aufruf einer Messung erfolgt über folgenden Befehl:

[...]

% Schließe die RPLiDAR Verbindung

[result] = DisconnectRPLIDAR(pRPLIDAR)

DestroyRPLIDAR(pRPLIDAR);

clear pRPLIDAR; % unloadlibrary might fail if all the variables that use types from the library are not removed...

unloadlibrary('hardwarex');

disp('Verbindung wurde aufgehoben')

Koordinatentransformation polar- zu kartesisch

Um die Messwerte darstellen zu können bedarf es einer Umrechnung von Polarkoordinaten (Radius und Radiant) in kartesische Koordinaten (x und y Koordinaten). Das rechte Bild stellt den Zusammenhang zwischen diesen beiden Formen dar. Folglich wird folgende Formel im MATLAB Code verwendet:

Folgender Code berechnet die kartesichen Koordinaten in MATLAB:

x = alldistances.*cos(allangles); % Koordinatentransformation in X-Achse

y = alldistances.*sin(allangles); % Koordinatentransformation in Y-Achse

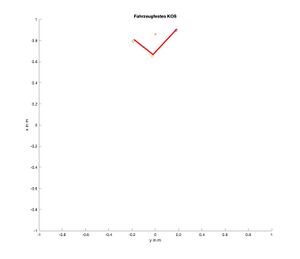

LiDARfests KOS zu Fahrzeugfestes KOS

Für den weiteren Verlauf wird das Koordinatensystem auf das Fahrzeug übertragen. Hierzu werden folgende Werte:

- Index: L (LiDARfest)

- Einheit/Skalierung: m

- Ursprung: Mitte

- x-Achse: nach links/rechts

- y-Achse: nach oben/unten

- z-Achse: keine vorhanden

auf das folgende Koordinatensystem transformiert:

Fahrzeugfestes KOS

- Index: K (körperfest, karosseriefest)

- Einheit/Skalierung: mm

- Ursprung: Mitte Vorderkante des vorderen Stoßfängers des Fahrzeugs (z = 0)

- x-Achse: nach vorne (im Sinne der Hauptfahrtrichtung)

- y-Achse: nach links

- z-Achse: nach oben

Hierzu wird eine Distanzmatrix erstellt, die für die Transformation verwendet werdet. Diese Distanzmatrix bezieht sich auf das Fahrzeug, mit der Fahrzeugabmessungen auf die Werte subtrahiert werden. Mit diesem Schritt werden die Abstände von Objekten auf das Fahrzeug übertragen, sodass z.B. beim einparken nicht vom LiDAR aus gemessen wird. Nachfolgend der Code für die Distanzmatrix und die Transformation:

% Distanzmatrix

distanceX = -0.008; % in m (80mm)

distanceY = -0.0145; % in m (145mm)

[...]

% Transformation von LiDARfesten ins Körperfeste KOS

x=[Segment(cnt).LeftCartesian(1)-distanceX Segment(cnt).NearbyCartesian(1)-distanceX Segment(cnt).RightCartesian(1)-distanceX];

y=[Segment(cnt).LeftCartesian(2)-distanceY Segment(cnt).NearbyCartesian(2)-distanceY Segment(cnt).RightCartesian(2)-distanceY];

Objektbildung

Es gibt mehrere Varianten eine Objektbildung durchzuführen. Für das Projekt jedoch wurde ein Successive Edge Following (SEF) Algorithmus verwendet. Dieser Code vergleich dabei nebeneinanderliegende (durch den Winkel) Radius-Messwerte miteinander und falls diese eine kleine Differenz aufweisen wird ein Segment gebildet.

Links im Bild ist ein Beispiel für die Objektbildung dargestellt. Dabei sind die blauen Punkte Messwerte vom RPLiDAR und die roten Linien sind die gefundenen Objekte (Segmente). Einzelne blaue Punkte werden aufgrund des Nahbereichs oder eines zu großen Abstands zueinander nicht berücksichtigt (gefiltert)

Aus diesen Segmenten lassen sich Objekte bilden. Die Objekte werden mit einer Breite, Tiefe und Objektausrichtung bestimmt.

Attribute

Softwareentwurf in C-Code

Test der Kommunikation Kamera/LiDAR mit DS1104

Diagnoseseite in ControlDesk

Plausibilisierung der Messdaten (LiDAR, Kamera)

Abschätzung der Güte der Spurerkennung und des Objekttrackings

Getting started

→ zurück zum Hauptartikel: SDE Praktikum Autonomes Fahren